信安标委:人工智能产品服务应为用户提供拒绝和停用机制

南都讯 记者冯群星 11月9日,全国信息安全标准化技术委员会官网公布了《网络安全标准实践指南—人工智能伦理道德规范指引(征求意见稿)》。该文件将人工智能相关活动划分为研究开发、设计制造、部署应用、用户使用四类,并针对每一类活动提出相应的指引建议。

《网络安全标准实践指南—人工智能伦理道德规范指引(征求意见稿)》目录。

据了解, 《网络安全标准实践指南》是由全国信息安全标准化技术委员会(以下简称“信安标委”)秘书处组织、制定和发布的标准相关技术文件,旨在围绕网络安全法律法规政策、标准、网络安全热点和事件等主题,宣传网络安全相关标准及知识,提供标准化实践指引。

此次发布的《网络安全标准实践指南—人工智能伦理道德规范指引(征求意见稿)》(以下简称“征求意见稿”)将人工智能相关活动划分为四类,并对“人工智能”“研究开发者”“设计制造者”“部署应用者”“用户”等术语作出了定义。

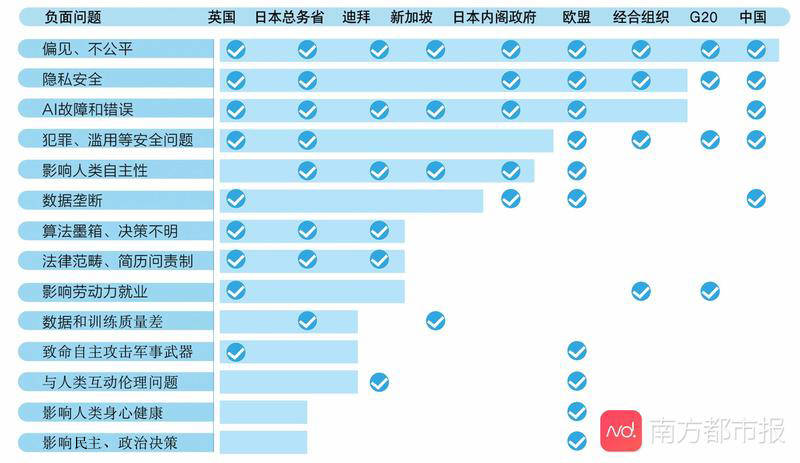

人工智能伦理道德风险一直备受关注。自2018年以来,全国多个国家、组织就风险防范发布了指南性文件,据南都记者盘点,这些文件中提到的伦理道德风险包括15类,数据偏见、不公平等问题提及次数最多,其次是隐私安全和AI故障、错误决策等问题。

不同国家、组织关注的人工智能伦理道德风险。

征求意见稿也专门设置了一节介绍人工智能伦理道德风险,并将相关风险归结为五类:失控性风险,指人工智能的行为与影响超出人类预设、理解、可控制的范围;社会性风险,包括人工智能的滥用、误用;侵权性风险,指人工智能影响到人的基本权利、人身、隐私、财产等;歧视性风险,人工智能对人类特定群体产生偏见,造成权利侵害或负面后果;责任性风险,人工智能相关各方责任边界不清晰、不合理,导致各方行为失当,对社会信任、社会价值产生负面后果。

在伦理道德的规范指引方面,征求意见稿既提出了总体的基本要求,也就四大类活动分别给出了指引建议。

南都记者注意到,这些建议主要围绕人工智能系统、产品和服务的可解释性、可靠性、透明度、恶意应用、事故应急处置、风险救济等方面展开。

在针对设计制造、部署应用的建议中,征求意见稿均提出,相关活动主体应向用户及时、准确、完整、清晰、无歧义地说明人工智能相关系统、产品或服务的功能、局限、风险以及影响,同时应设置事故应急处置机制,明确事故处理流程,确保事故发生后的及时响应。

从“大数据杀熟”到“外卖骑手困在系统里”“江西阿姨爱上假靳东”,大量的既有案例表明,用户很难了解人工智能的功能与运行机制,往往只能被动接受系统的自动化决策。征求意见稿的要求,或许将推动此类困境的改善。

值得注意的是,在部署应用方面,征求意见稿还强调,相关主体应以清楚明确并便于操作的方式向用户提供能够拒绝或停止使用人工智能相关系统、产品或服务的机制;在用户拒绝或停止使用后,应尽可能为用户提供非人工智能的替代选择方案。

在用户使用方面,征求意见稿则提出,用户应主动了解人工智能伦理道德安全风险,积极向研究开发者、设计制造者、部署应用者反馈人工智能伦理道德安全风险相关信息。

征求意见的截止时间为11月23日。有意见或建议者可反馈至信安标委秘书处。

信安标委官网链接:

https://www.tc260.org.cn/front/postDetail.html?id=20201109163419

- 用户评论