如何通过雷达攻击自动驾驶汽车-针对点云识别模型的对抗性攻击的科普

01

引 言

随着自动驾驶技术的迅速发展,雷达和激光雷达等传感器在自动驾驶汽车中的作用愈发重要。它们能够生成3D点云数据,帮助车辆实时感知周围环境并做出安全决策。然而,尽管这些传感器对驾驶环境的检测非常精确,它们也面临一种新兴的威胁——对抗性攻击。

对抗性攻击是一种通过微小但精心设计的扰动,旨在欺骗机器学习模型的攻击方式。对于自动驾驶系统而言,这意味着通过对传感器输入的数据进行极小的修改,攻击者可以导致自动驾驶汽车对其周围环境作出错误的判断。例如,在点云识别模型中,攻击者可以通过扰动点云中的数据,使得车辆无法正确检测障碍物或行人,从而引发严重的安全事故。

这种攻击方式的危险在于,扰动往往非常微小,但它足以误导深度学习模型。例如,通过使用针对3D点云的对抗性攻击,攻击者可以制造虚假目标,或隐藏真实目标,使车辆在物理世界中无法正确响应。这些攻击不仅对自动驾驶的安全性构成重大威胁,也对自动驾驶系统的鲁棒性提出了新的挑战。

02

针对点云识别模型的对抗性攻击

2.1 2D对抗性攻击方法向3D点云模型迁移的挑战与难点

2014年,Goodfellow等[1]的研究指出,在待识别图片中巧妙地加入一定的噪声,会使得图像被神经网络误分类。同时,该研究也揭示了神经网络的脆弱性,使得神经网络的攻击方法成为了近年来深度学习的研究热点之一,随后,出现了大量针对图像的对抗性攻击方法。如Su等尝试使用更改图像的单个像素的方式完成对神经网络的攻击,该方法通过改变图像中的单个像素观察神经网络输出概率的方式,搜索最终生成对抗样本需要更改的像素,Wang等提出一种使用替代模型训练可迁移的对抗样本的方法,通过训练一定数量的替代网络生成可迁移的对抗样本。

但这些方法都难以直接迁移应用至点云识别模型的攻击中:首先,2D的图像和3D的点云数据结构上存在巨大的差异,2D图像中的像素是有序的,按行列排布,而3D点云数据中的点是无序的,点的排列顺序对点云的几何结构没有影响。这使得许多直接基于像素位置的2D方法无法简单迁移到3D点云中,因为点云没有固定的排列结构。另外,3D点云相比于2D图像通常更加稀疏。点云中的每个点可能包含有限的邻居点,而2D图像中的每个像素通常都有固定数量的邻居。这种稀疏性增加了在3D点云上生成有效对抗性样本的难度。还有,2D图像和3D图像的坐标空间不同,在2D图像中,像素位于离散的二维网格中,而3D点云的数据位于连续的三维空间中。攻击者在2D图像上进行的像素扰动非常直观,而在3D空间中,修改点的坐标会影响物体的形状、姿态和几何结构,使得在生成对抗性样本时需要更复杂的几何变换。3D点云模型对旋转和平移等几何变换相对敏感。使得对抗性攻击在3D点云模型上相比于2D图像识别模型更容易受到空间和角度的变化所影响最终导致失效。最后,3D模型的对抗性攻击相比于2D模型计算量更大,3D数据的处理往往比2D图像复杂得多,计算成本更高。在生成对抗性样本时,算法需要处理大量点,这显著增加了时间和资源的消耗。

2.2 针对点云识别模型的对抗性攻击算法介绍

虽然将2D模型的对抗性攻击方法迁移至3D点云的攻击方法存在诸多挑战,但还是有研究人员成功地将应用于2D模型的对抗性攻击方法迁移到了针对3D点云模型的方法中。Xiang等[2]提出了一种基于C&W的攻击方法,称之为3DAdv。3D Adv采用了C&W作为寻找对抗性特征使用的待优化函数,采用Chamfer距离用于衡量两个点云之间的相似性,通过梯度下降的方法求解出最后的对抗性特征。3DAdv采用了Chamfer距离来度量原始点云与扰动点云的相似性:这使得扰动后的点云在几何结构上依然保持与原始点云的高度相似,同时允许针对特定点的微小扰动,采用Chamfer距离很好地解决了L2范式等方法无法应用于评估点云之间的相似度问题,一定程度上解决了3D点云的无序性问题和稀疏性问题。3D Adv虽然在一定程度上解决了点云数据和图像数据特征不一致的问题,但其难以在现实世界中复现,另外还存在生成的计算复杂度高、适用范围有限等局限性。

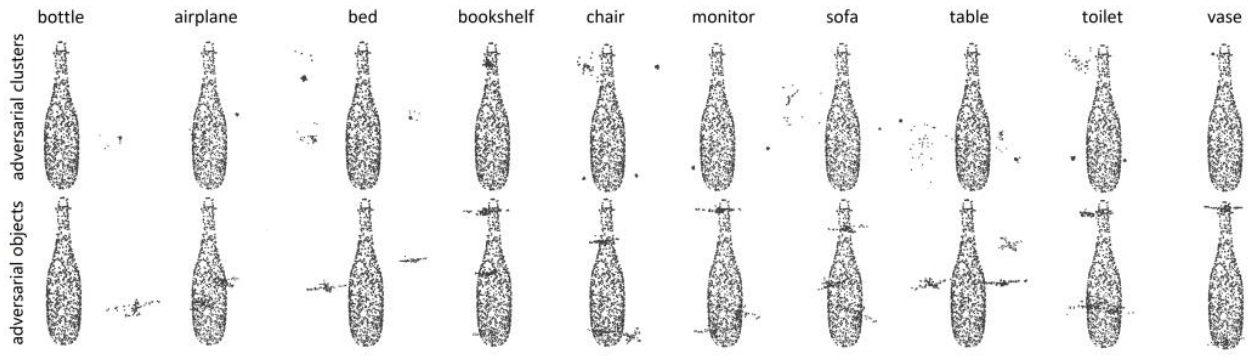

图 1 3D Adv可视化效果[2]

另外也有其它的研究者另辟蹊径,选择使用别的方法生成对抗性的点云。比如Harmi等[3]就通过对抗性生成网络进行对抗性点云的生成,对抗性生成网络由两个部分——生成器和判别器组成,生成器负责生成对抗样本,判别器用于评估这些样本的真实性。AdvPC 通过这种对抗性训练,生成在几何上与原始点云相似但能够欺骗分类器的对抗样本。通过这种方法生成的样本具有鲁棒性强、可迁移性强的特点:传统的基于梯度的对抗性攻击通常需要对目标模型进行专门优化,生成的对抗样本难以在不同模型之间通用。AdvPC通过生成模型,能够生成对多个模型都有效的对抗性样本。换句话说,生成的对抗样本具有较强的可迁移性,在不同的3D点云分类器中依然能够误导模型。另外,由于AdvPC结合了生成对抗网络的强大能力,它生成的对抗样本在一定的旋转、平移或噪声干扰下仍然能够保持有效。相比于直接的梯度攻击,AdvPC生成的对抗性样本更能适应实际的物理环境变化,适合在现实应用中使用。但是,AdvPC也存在自己的局限性:由于GAN的训练过程本身较为复杂,AdvPC的实现需要大量计算资源,尤其在生成高质量的对抗样本时,训练过程可能会消耗大量时间。另外,尽管AdvPC在数字环境中的效果显著,但将这些对抗样本应用于物理世界(如激光雷达数据)时,可能仍需要克服一些现实中的传感器噪声和环境变化。

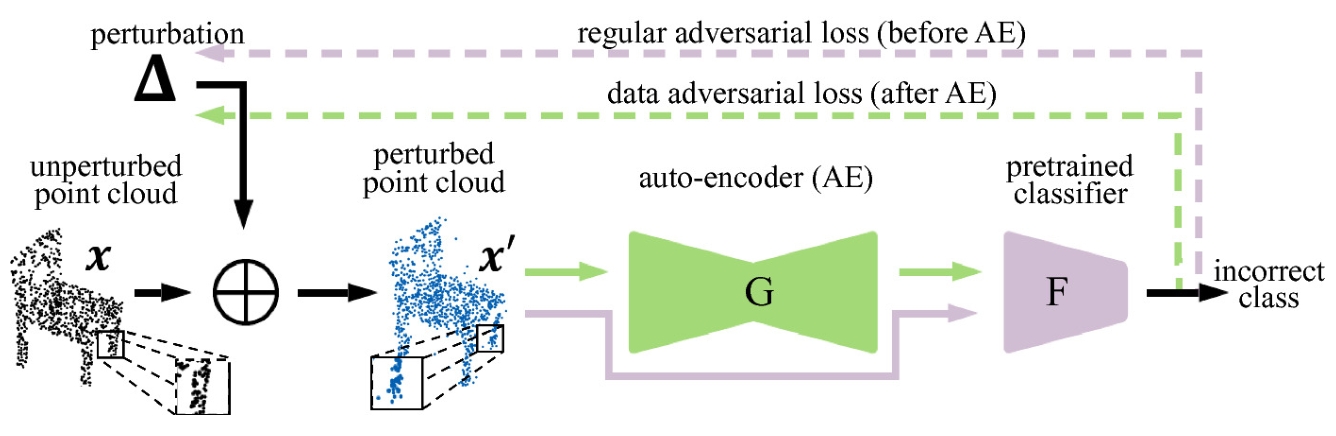

图2 AdvPC算法流程[3]

3DAdv和AdvPC除去自身的局限性,他们还难以应用于黑盒攻击的场景下。3DAdv需要知道模型的梯度信息,AdvPC需要知道数据的输入特征,在目标模型的信息完全未知只能知道目标模型的输入输出的情况下这种白盒的方法无法应用。为了解决这一问题,Cao等[4]提出了EvolutionAdv,EvolutionAdv 通过进化算法逐步优化对抗性样本。进化算法模拟自然选择过程,生成一组随机的扰动样本,并通过选择、变异和交叉操作,不断改进样本,使它们逐渐演化为能够有效欺骗模型的对抗性样本。EvolutionAdv 假设攻击者无法访问目标模型的内部结构或参数。因此,EvolutionAdv 不需要知道模型的细节,仅依赖模型的输出来优化对抗性样本。相比于前文提到的3DAdv和AdvPC,EvolutionAdv无需了解模型的内部结构、梯度或参数。这使得它非常适合攻击那些对外界保密的模型,如商用模型或云端提供的深度学习服务。但同样的EvolutionAdv同样存在计算上比较复杂,生成对抗样本的时间较长,效率较低等问题。

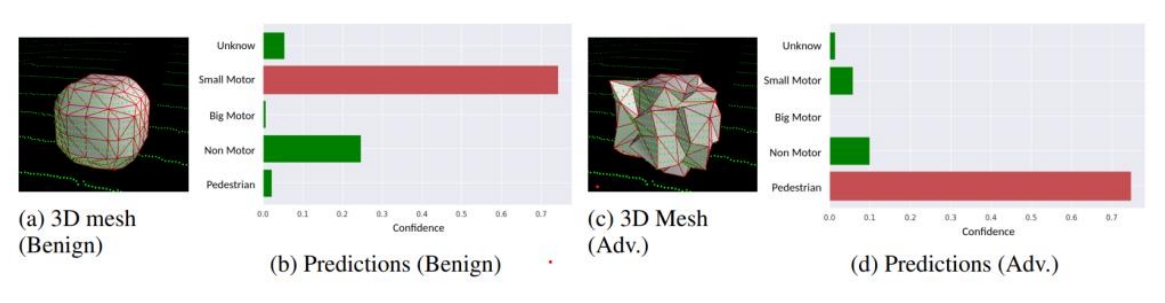

图3 Evolution Adv攻击效果可视化[4]

除去直接修改点云的方式以外,还有一种利用几何变化的对抗性攻击方法TSI[5],它的核心思想是通过利用三维几何变换保持对抗性样本在不同几何条件下的有效性。在获取点云后,TSI会对输入的点云进行多次几何变换,并在每次变换后通过优化调整对抗性扰动,使得每次变换后的样本都能继续误导模型。通过使用最小化光谱范数作为评估攻击前后的相似性,TSI能够增强对抗性样本的几何鲁棒性,确保它们在面对旋转、平移等变换时依然能有效欺骗目标模型。这种方法在自动驾驶和机器人等应用场景中具有重要意义,因为它能够处理动态的3D环境,并提高对抗性样本的实用性。然而,TSI的计算复杂度和物理实现挑战仍然是该方法需要进一步解决的问题。

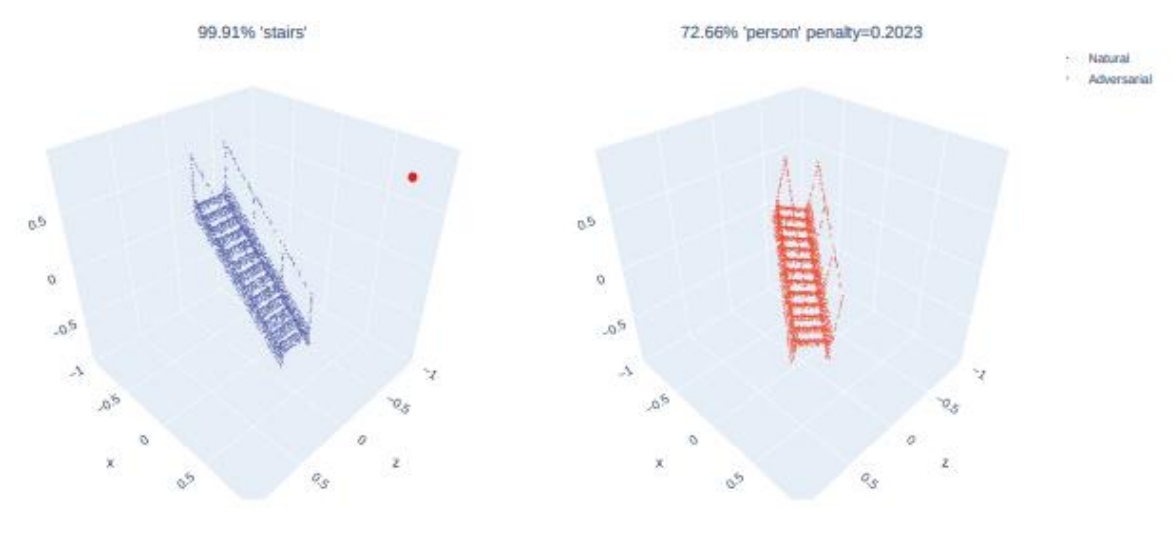

图4 TSI攻击可视化效果[5]

2.3 小结

在本章中,我们回顾了针对3D点云识别模型的几种主要对抗性攻击方法及其各自的特点和局限性。相较于2D图像的对抗性攻击,3D点云数据在无序性、稀疏性以及三维空间的几何特性等方面增加了攻击难度。3DAdv方法通过Chamfer距离保持几何相似性,以解决点云无序性和稀疏性带来的问题,但其高计算复杂度限制了应用的广泛性;AdvPC基于生成对抗网络生成对抗性点云,虽然具有较强的可迁移性和鲁棒性,但在物理环境中的表现仍需进一步提升;EvolutionAdv利用进化算法生成对抗样本,避免了白盒攻击的限制,但在计算效率上存在不足;TSI通过几何变换增强对抗样本的鲁棒性,在动态环境中表现出色,但也面临着计算复杂度和物理实现的挑战。

这些方法从不同角度出发解决了3D点云对抗性攻击中的部分难题,但每种方法都有其适用的场景与限制。未来的研究可以进一步优化这些算法,以降低计算成本、提升对抗性样本的鲁棒性,并增强其在实际应用中的可操作性。在3D点云识别领域,对抗性攻击的研究仍有广阔的探索空间,这不仅能够揭示模型的脆弱性,也为提高模型的安全性和鲁棒性提供了方向。

03

总 结

虽然现今已经存在不少理论上可以对点云模型进行攻击的对抗性算法,但这些算法在实际应用中仍然面临诸多挑战。首先,理论上的对抗性攻击大多是在理想的实验条件下实现的,实际环境中的复杂性和不确定性(如传感器噪声、动态光照条件、目标物体的多变性等)可能导致对抗样本失效。特别是在自动驾驶场景中,车辆需要处理不断变化的外部环境,对抗性样本必须具备较强的鲁棒性,才能在现实条件下误导系统。

此外,物理可实现性仍是一个重要的瓶颈。许多对抗性攻击算法是在数字空间中操作点云数据,而当这些扰动点云转换到物理环境中(如激光雷达、相机等传感器实际捕捉的物体),其攻击效果可能会大打折扣。攻击样本必须经过调整,以确保在不同的物理传感器和环境条件下仍能保留其对抗性。同时,点云数据的稀疏性和无序性也对攻击算法的物理实现提出了新的挑战,如何在物理世界中精确施加微小的扰动来影响3D点云仍然是一个未解决的问题。

其次,计算复杂度和资源消耗问题在实际应用中尤为突出。大多数对抗性攻击算法需要经过多次迭代和优化,才能生成有效的对抗性样本,这在计算资源有限或要求实时处理的自动驾驶应用中是一个巨大挑战。例如,EvolutionAdv 等基于进化算法的方法,虽然在黑盒攻击中表现优异,但其迭代过程复杂,生成对抗样本所需的时间过长,难以满足实时性要求。类似的,AdvPC 依赖于生成对抗网络(GAN),虽然提高了对抗样本的可迁移性和鲁棒性,但GAN的训练开销巨大,尤其是在处理大规模3D点云数据时,计算资源需求较为庞大。

最后,3D点云对抗性攻击的可解释性与安全性依然是亟待解决的问题。对抗性攻击的生成过程往往涉及复杂的数学优化和大量计算,使得对抗样本的行为难以理解和预测。这种可解释性缺失使得自动驾驶系统设计者难以预防攻击,甚至在攻击发生后也难以追溯根源。此外,在实际应用中,为了确保车辆和行人安全,必须在算法开发阶段和模型部署前引入有效的防御机制。然而,现有防御方法在3D点云数据上效果有限,大多是针对2D图像的算法简单延伸,尚未针对3D点云特性设计出适应性强的防御策略。因此,尽管已有多种理论上的对抗性攻击算法被提出来,如何在真实的自动驾驶场景中实现稳定有效的攻击仍存在巨大挑战。未来的研究可以集中在提高对抗性攻击算法的物理可实现性、增强其鲁棒性和可解释性、以及设计更高效的计算方法上,以应对自动驾驶和其他应用场景中的实际需求。同时,研究社区也需要开发针对3D点云的专门防御策略,以在对抗性威胁下保护自动驾驶系统的安全和稳定性。

- 用户评论