特斯拉Autopilot最新版本对于行人的识别分析

最近我们谈Tesla的Autopilot系统功能比较多。这其中最主要一个是因为近期Autopilot系统的迭代速度确实比较快,至少相比同期的2019年的第一季度要快很多,作为标志性的自动驾驶系统实现,有必要亦步亦趋地紧紧跟随,这将保证我们对于产业标杆的理解;另外,也还是因为最近的Autopilot版本迭代,所携带推出的自动驾驶识别系统的相关功能比较集中,而绝非仅仅是车载娱乐系统的升级(当然这也是重要的分系统)这么简单,这也是我们非常关注的。Tesla的Autopilot是走在业内前列的自动驾驶系统,不论从处理庞大车队的Level-2功能普及角度看、还是从把大量Level-3甚至Level-4才需要的基础功能下放到现行Level-2基准的车队上实现角度看、甚至从自动驾驶功能的UI操作逻辑上看,Tesla都是花费了大量的心思,可以说硕果累累,值得学习。

我们都知道在自动驾驶产业内,走得最远、产业化最完备的两条线路,其中一条是Google的Waymo所主导的自动驾驶“服务路线”。在Google的设想中,所有的自动驾驶系统和承载车辆(包括硬件和软件),都由Waymo一把抓。从车辆定制、传感器定制、自动驾驶系统的研发和后台的测试和仿真,Waymo一肩挑,基本上不对外开放任何硬件和软件实体,一直到自动驾驶技术成熟再到市场准入后,搭配上安全员上路,拉客营业。小编能力所限,眼光不高…… 因此小编无法理解Waymo的商业模式闪光点到底在哪里?如果一步跨入“自动驾驶服务行业”,那么早期巨大的硬软件研发费用,真的可以覆盖并顺利回收,而让Waymo自身保持健康?唔……..可能只有财大气粗的Google才能意识到这种玩法的最终答案吧!

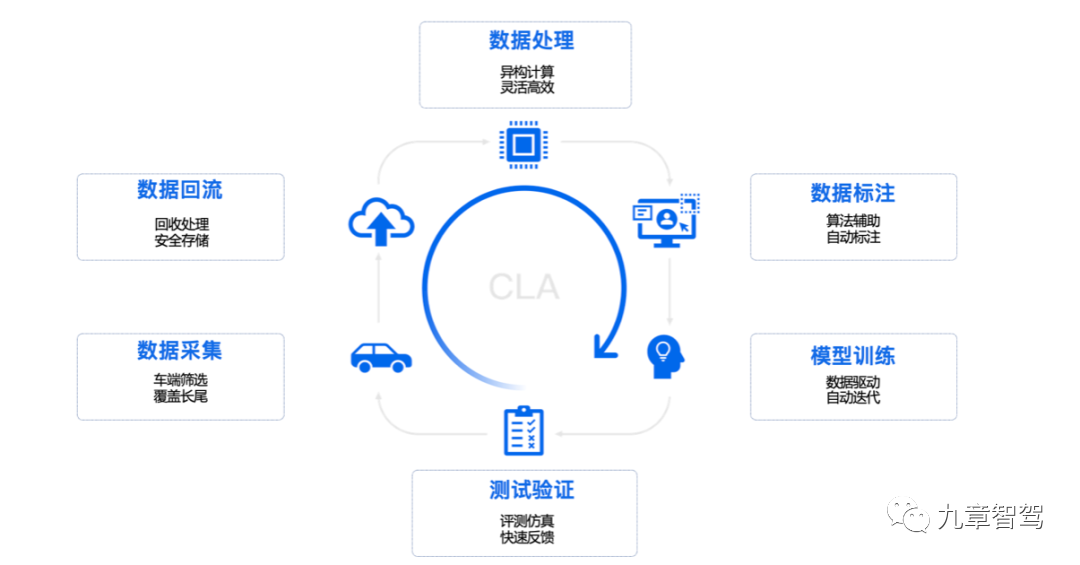

实现角度上讲,虽然Waymo的自动驾驶出租车车队规模已然是不算小了,运营的地理范围也挺可观,但实际的自动驾驶里程(这是标志你是否成熟可靠的核心指标)和Tesla的商用fleet还是不在一个数量级上,具体的指标大家可以去翻翻waymo的官方站点数据。遵从工业界的一般规律,Waymo实际上更加依赖的是仿真里程。只要合理规划,仿真在技术实现度上逼近真实场景,在仿真领域累计大量的“驾驶经验”对于多数的自动驾驶厂商来说,未尝不是一个替代方案。

根据前段时间Waymo的数据披露,Waymo自动驾驶出租车队在实际的运营过程中,人类安全员的干预程度已经很低了,但整体运营的安全性却一直保持不错的成绩。因此我们相信在这个Waymo的技术线路中,“仿真系统和技术”扮演了不可或缺的角色。这也许和Google一贯的技术化、数字化的过硬风格相关。

顺便插播个小广告,有兴趣了解数字化的“自动驾驶仿真系统”的业内同行,可以和我们车右智能多交流。我们是专业的自动驾驶仿真系统搭建者。

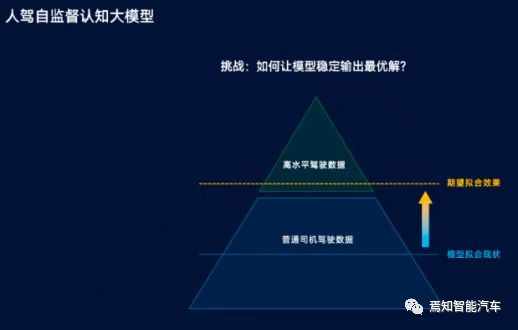

另外一条线路,就是我们日常生活中随处可见的Tesla的Autopilot实现线路。它足够特殊,特殊到我们找不到任何一家类似的自动驾驶/车辆制造企业能够采用和Tesla完全一致的产品/系统演进手段。在技术上,Tesla的特殊性反映在:第一,几乎完全依赖视觉系统进行自动驾驶实现;第二,永远坚持从实际场景出发。从Level-2辅助驾驶的能力出发,将关键自动驾驶的目标识别、路径规划、执行等等技术拆开打散,揉进每一辆有人类驾驶员驾驶的Tesla车辆当中去;第三,在庞大基数的Tesla Fleet车队上实现闭环调试和稳步迭代,小步快跑。【注意,在Autopilot系统的功能“开发——部署——反馈——修正——部署”的大闭环当中,仿真只扮演辅助作用。】

更惊人的是,如果消费者意识到,Tesla实际上在以一个对他自身来说很合算的商业模式(车辆出售、自动驾驶系统出售),再逐步构建和完善的Autopilot系统能力,那就更加不得不赞赏这种实践方式了。呵呵了,简直完美!每个Tesla的车主,都是免费的“安全员”。

当然,金无足赤,无可规避的是,连带的驾驶安全的道德责任,这也是Tesla最大的潜在隐患。在现有Level-2的Autopilot系统上部署过多的自动驾驶功能,在很多时候也会误导人类司机,从而造成各种严重后果。如果类似问题得不到持续一贯的严格管控,负面后果逐日的累加,也可能在很大程度上削弱Autopilot的可信度。这对Tesla的品牌形象来说,是致命的。

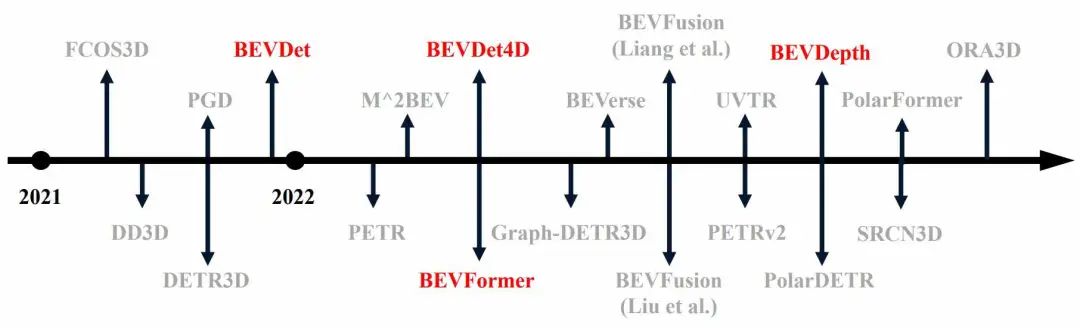

在我们公众号的前期系列中,我们曾经花费大量的篇幅介绍Autopilot的识别系统和闭环训练的法则,也曾经谈到Autopilot中部分功能的实际运营效果。今天的专题依然是一个新版本2020.16.2.1所带来的新功能——Pedestrians Animation/行人动画。让我们持续跟踪autopilot每一个版本中的技术细节和效果,这将有利于我们对于业内最高水准的判断。

2020.16.2.1中,主要的升级包含三个方面。第一是全新的Toy Box车载娱乐版面的调整;第二是提供了便捷的USB存储驱动器格式化功能,而无需借助标准的PC设备;第三是全新的Tesla充电站搜索功能支持分级别的充电桩地点搜索;第四是我们今天要谈到的,针对行人的识别和动画显示功能。

上图展示正面面对垂直侧向通过行人,动画显示准确,形态甚至步态都很写实。

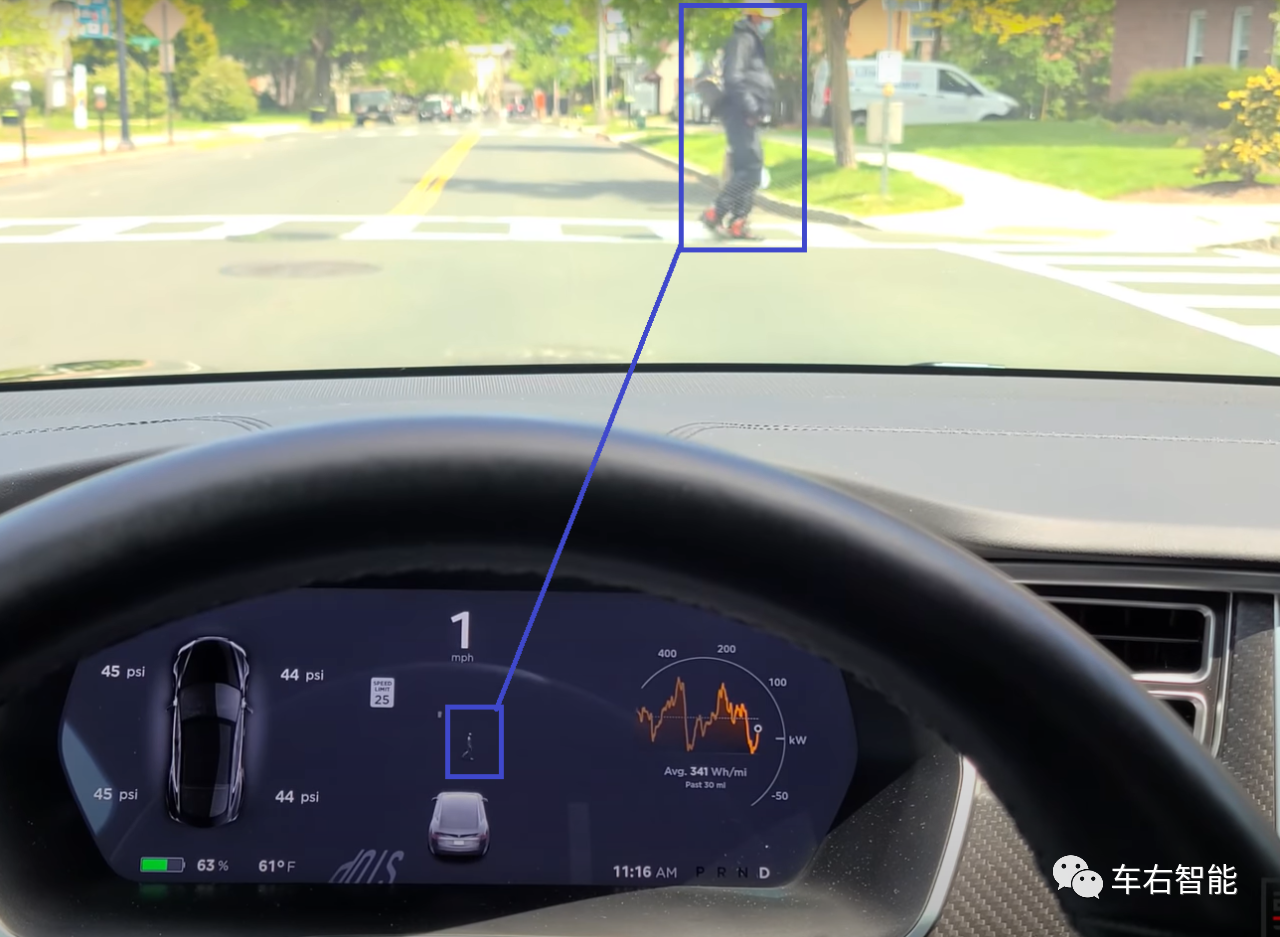

上图三连发。当Tesla车辆低速接近路边车辆时,在20m-30m的距离上率先识别出车辆实体,然后跟着识别出车辆后面的人体,最后在几乎零距离上,忽略车体只保留了人体。这是实际观察到的现象。至于这是不是一种稳定的现象,还不清楚。但是可以推测的是,当道路路面上目标重合时,Atuopilot的视觉识别还是有不小的计算量,因此才会出现识别结果的跳跃。

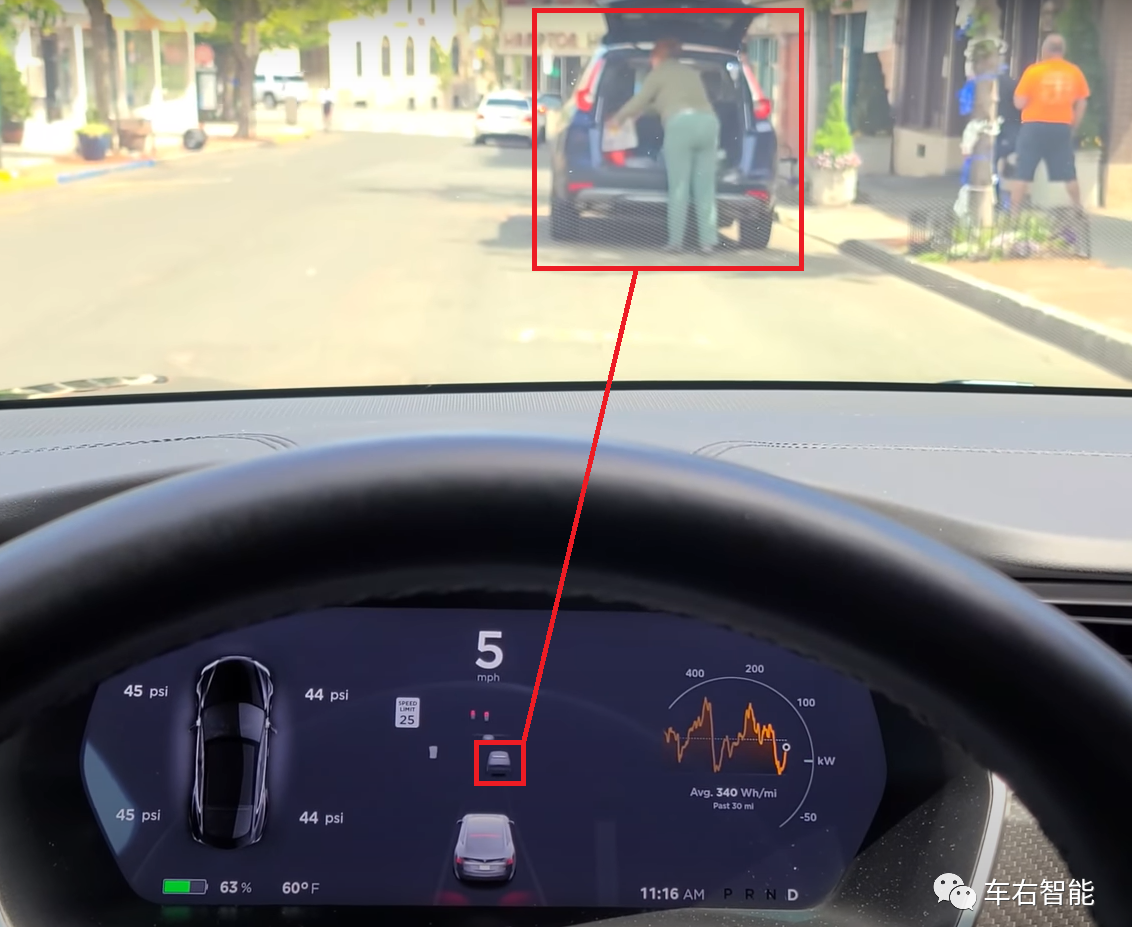

上图显示了,对向左侧跑步状态的行人识别,在驾驶仪表面板上,跑步人体的速度和方向都正确。

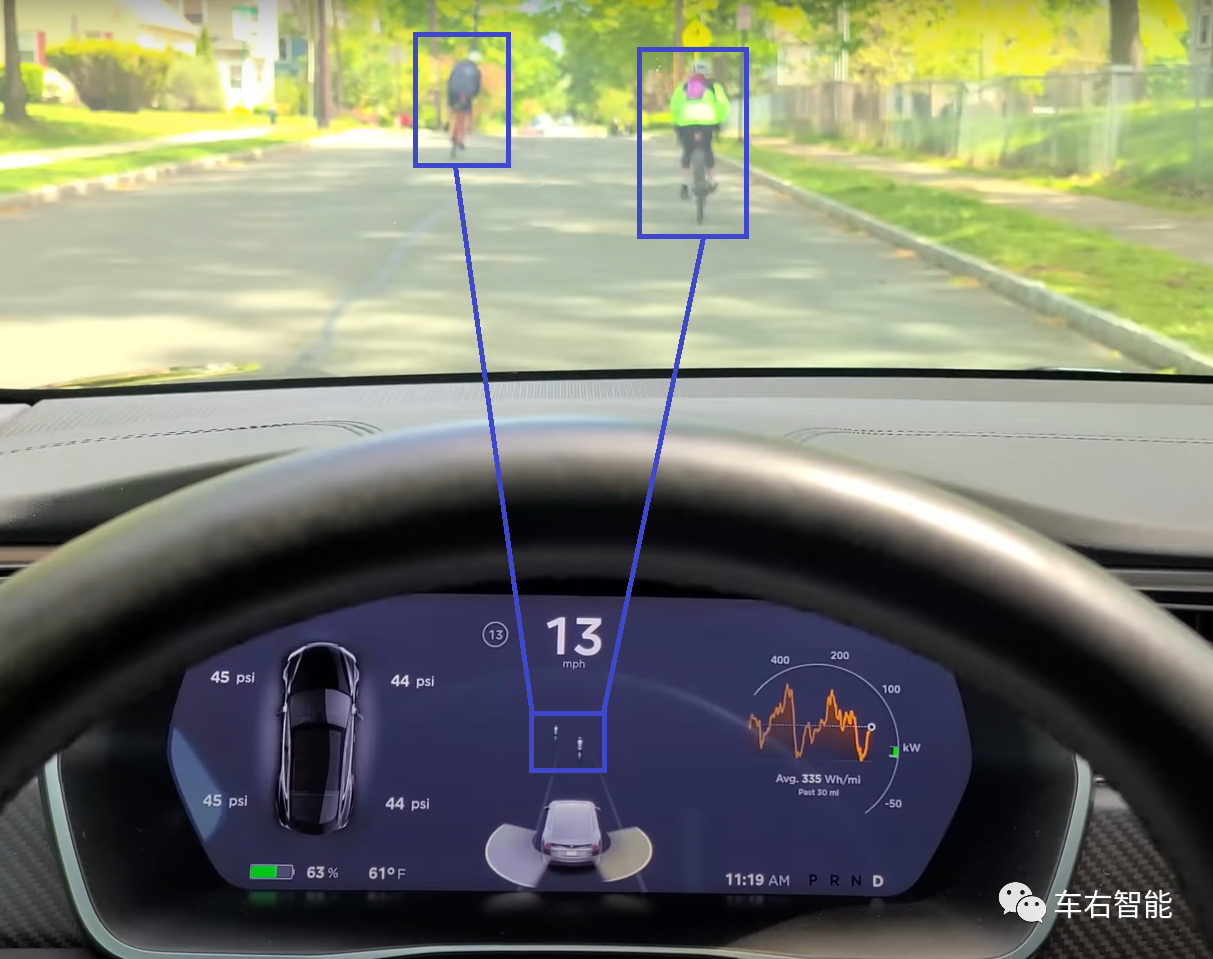

上图显示对于骑自行车的人的识别。

上图显示正向垂直状态过节行人,多人,的识别状态。

上图中显示一个顺向过马路的行人(闯红灯状态),但是Autopilot把他识别成一个垂直方向的过马路的行人。不准确。

通过对以上实际场景下的记录观察,PedestriansAnimation/行人动画总体效果还可以,但和Autopilot的其它识别结果来做对比的话,还是不够稳定,也不够准确。我想我们能在实际产品中观察到的现象,对于Autopilot的系统设计者和开发者来说,在试验阶段就可以观察得到。这是为什么对于一些厂家来说,Lidar是个不二的法则,因为Lidar才应该是近场观测/测量最准确的那个技术。Tesla和Elon Musk尽管对于Lidar嗤之以鼻,而且Lidar上车也确实有这样和那样的实际问题,但这不影响我们对于Lidar这个技术的判读。

对比之下,单纯的视觉技术还是有很长的路要走。就目前Autopilot行人动画所表现的稳定性、可靠性和精确性来看,还是不够的。

那么另一个问题浮出水面,既然不对行人识别做任何控制级别的判断,那么为什么要在这个阶段开放这个功能到仪表板上呢?仅仅是为了好看和吸引人类驾驶员嘛?我想应该不是,Tesla一步一步展示越来越多的识别技巧,但在自动驾驶控制回路上始终保持Level-2…… 这里面应该有很多学问。

本期观察结束,谢谢。

车右智能

info@co-driver.ai

- 用户评论