ADAS/AD评论02-智能驾驶域与智能座舱域的融合

前言

这两年,不少车厂发现高级自动驾驶短期落地难度有点大。且不说自动驾驶系统自身的问题(激光雷达成本、高精地图和高精定位落地、高算力低功耗车规级芯片等等),从功能安全角度设计,发现一些相关系统,比如制动、转向等系统的冗余方案,还要等博世等Tier1的冗余执行器推出来。太难了,哪个系统都不省心,都不ready。所以战线收缩了,不少OEM转而把枪头对准相对好落地智能座舱去了。

座舱智能化及最终演变

谈到汽车智能化,大部分人想到的是智能驾驶。实际上,智能化有两大发展方向:驾驶自动化(Driving Automatization)和座舱智能化(Cockpit Intelligentization),智能驾驶(ADAS/AD)和智能座舱(i-Cockpit)则是两个方向的重点落地功能。前者能将人从动态驾驶任务中释放出来,后者促成座舱数字化、信息化、多功能化,但最终会融合在一起,结合网联化,推动汽车向“第三生活空间”转变。

想像一下,若没有驾驶自动化,就无法释放人的脚(纵向控制)、手(横向控制)、眼(感知、监控)、脑(决策、精力),精力都在开车上,数字化座舱、可折叠数字方向盘、灵活布局的座椅、智能办公套件又有多少使用场景?不过是另一种形式的房车或露营车罢了,无法支持动态通勤场景下的办公、休闲、娱乐活动。同样,若没有座舱智能化,释放“脚-手-眼-脑”的意义又在哪里?实际上,人们对驾驶自动化的期待并不在其本身,而在于驾驶自动化实现之后的座舱智能化。那种集通勤、办公、休闲、娱乐于一体的“第三空间”,才是汽车智能化的终极应用场景。试想在自动驾驶功能加持下的汽车座舱,可以支持各种设备的智能化折叠(方向盘折叠,甚至在无人驾驶阶段直接取消方向盘),支持移动座椅并随意布局,为乘员提供更舒适更灵活的空间提供保障。

图1为伟世通对智能座舱与智能驾驶的发展趋势判断。伟世通认为在新E/E架构帮助下,座舱域ADAS/AD最终会整合在一起,真正实现车辆的智能化控制。

图1 伟世通对座舱和ADAS/AD技术的发展趋势预测

图1 伟世通对座舱和ADAS/AD技术的发展趋势预测

为满足智能座舱未来的多功能、多任务需求,需要对座舱域进行大刀阔斧的升级,如信息娱乐系统集成化、数字化、显示AR化; 以及座椅/方向盘/中控台等座舱设施的电子化、可折叠化(隐藏化)、移动布局化。其中后者需要智能驾驶达到一定程度,因此当前座舱智能化更多集中于信息娱乐系统的智能化,即数字座舱(Digital-Cockpit或E-Cockpit)功能的落地。

数字座舱由于功能复杂,首先要对原座舱域硬件进行整合。大众的ID3通过整合IVI(中控触屏)、IC(仪表)、HUD(抬头显示)等模块,通过ICAS3控制器直接控制IC、HUD、中控触屏等显示终端,形成高度集成的硬件平台,有效降低了整车成本,优化车内空间,减小功耗,也可整合操作系统(搭载VW.OS),实现软硬件分离,开启“软件定义汽车”第一步。

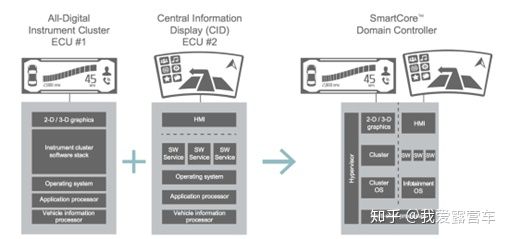

类似地,伟世通的SmartCore座舱域控制平台通过将座舱域多个ECU集成到一个控制器上,整合IVI、HUD、驾驶信息、多功能信息显示以及ADAS和车联网的信息资源(如图2),帮助OEM对座舱显示进行集中规划,为HMI和交互方式提供更多灵活性,为多样化的自动驾驶场景应用提供交互保障。否则,分散的座舱域ECUs难以与安全域(ADAS/AD)控制器协同工作,无法实时地将GPS、Radar、Lidar和摄像头的实时环境信息展示给用户。

图2 域控制器对传统座舱域ECU的整合

图2 域控制器对传统座舱域ECU的整合

数字座舱相对智能驾驶最大的不同在于:前者重点在于人机交互和信息服务体验,安全风险较小;后者要控制车辆行驶,责任重大,落地难度也成倍增加。这也是国内不少OEM的智能化重点从ADAS/AD转向E-Cockpit的原因。另外,从人力资源角度讲,信息娱乐、UI交互、多媒体、导航等功能在PC&移动互联网行业已有丰富高水平人才储备,利于数字座舱的推进。这也给BATH(百度、阿里、腾讯、华为)等互联网公司提供了很大的想象空间。

如果无人驾驶真的实现了(L5,取消方向盘和踏板那种;区分L0-L2的ADAS和L3-L4的AD自动驾驶),我想“座舱”的概念也就不复存在了。因为无人驾驶汽车的实体概念应该已经退化成为了一个“移动底盘”。“座舱”的概念会真正转化为“房子”,是一间除了家里原本那个三室两厅房子之外的另外一个“移动卧室”或“移动书房”。而这个时候的“房子座舱”与无人驾驶底盘一定是分离的。“房子座舱”是私有的,平时对接到自己的房屋中(那个时候的房地产可能也会变,楼房可能会变成水泥架子,里面停满了“房子”,你可以想象一下高级可折叠可变形的集装箱,停在比如8幢1203房位号之类的“停房位”,当然都可以搭载到无人驾驶地盘上进行“搬家”,水电气网做成统一接口,即插即用),用时召唤一辆公用化、共享化的无人驾驶底盘,拉着电梯送下来的“系统卧室或书房”进行出行服务。无人驾驶底盘的保有量一定大大少于“房子座舱”的数量。

触摸屏不是交互“终点”

特斯拉虽不是第一个在车中使用触摸屏的车企,却是将超大触摸屏变成科技代名词的企业。配备了17英寸“超级触摸屏”的特斯拉ModelS/X,直到几年后的今天,仍旧是吸引众多消费者的一大亮点。之后,其他车企也争相采用了大屏设计,比如Marvel X,采用了19.4英寸屏。

Model S/X 17英寸大屏

Model S/X 17英寸大屏

那么问题来了,触摸屏的交互方式真的是“终极方案”吗?未来智能座舱的进化,是否有更完美的解决方案呢?

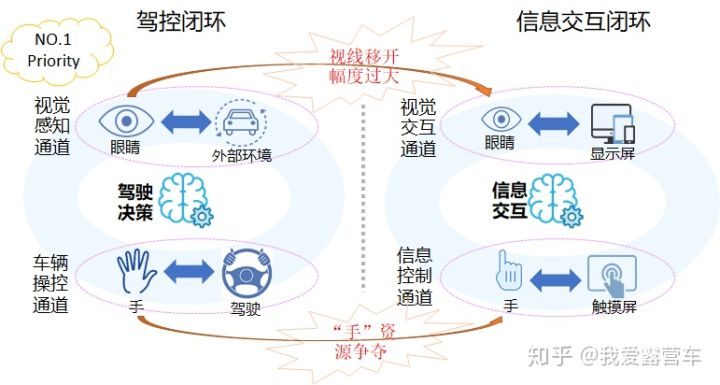

事实上,触摸屏的使用会对驾驶资源形成直接竞争。如下图所示,驾驶员在驾车时需要“手-眼”并用,才能形成完整的驾控闭环。而驾驶员针对触摸屏的每次交互,都要同时使用“手-眼”资源,与驾控闭环形成资源竞争,容易分散驾驶员注意力,不利于安全驾驶。

驾控闭环与信息交互闭环对“手-眼”的资源竞争

驾控闭环与信息交互闭环对“手-眼”的资源竞争

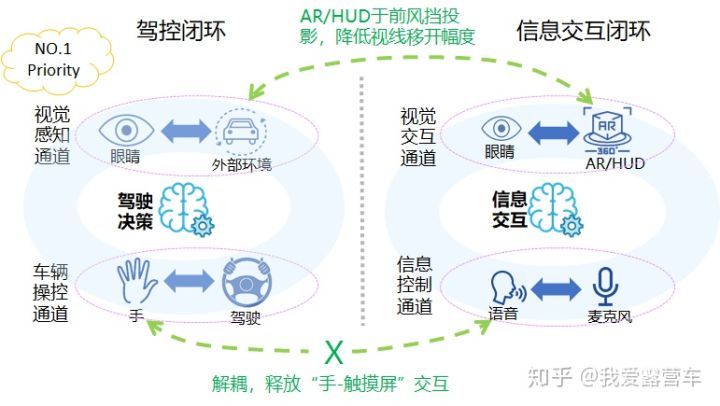

因此,HAD落地之前,交互设计必须以驾驶任务为中心。更好的设计方案一定是尽量少的占用“手-眼”资源的方案,即取消触摸屏,采用“语音-HUD/AR”的智能多模交互(下图)。“语音”可以释放“手”资源;HUD/AR能尽量较少驾驶员视线和注意力从车辆前方移开,保证行车安全。

“语音-AR”信息交互方式

“语音-AR”信息交互方式

即便如此,这种交互方式仍旧是被动的。智能座舱需要的“终极”交互方案,应该是车对人的主动式交互。即结合车外环境、车内视觉、语音识别、AR等多种感知手段,将车辆打造成为像钢铁侠“贾维斯”那种人工智能“管家”,才能全方位提升车主体验。例如,AR导航与传统导航相比,展示的细节更多(车辆、车道线和行人等),需要车外视觉感知结果的输入;主动性交互则需要通过车内摄像头精准判断车内所有生命物体,融合按键、语音等,基于场景来主动“察言观色”。

- 用户评论