特斯拉Autopilot处理Cut-in的策略分析

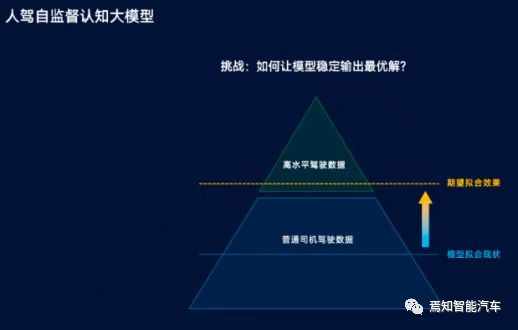

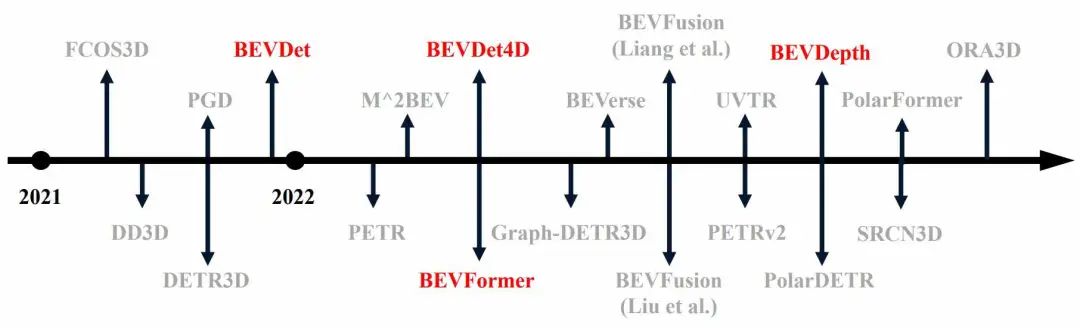

去年的Tesla四月份的Autonomous Driving开放日上,Tesla的核心团队以及Elon Musk本人都露了面,讲了从硬件(HW3.0)到软件(Autopilot的实现方法)的诸多方面。Karpahty的主题演讲中也谈到了对于Cut-in(变道插车)问题的处理方式。当时看起来并没什么特别令人印象深刻的地方,毕竟ImitationLearning/模仿学习也不算新鲜。

但是如果现在回头看,特别是有诸多的Tesla车辆“事故”佐证,则可以更深更好地理解Autopilot的运作本质。我们本期还是拿深圳这起Model 3事故来回头验证Tesla的理论。如下图参考,以时间线为轴:

1 BYD电动卡车换道之前的态势:

当相邻车道的BYD电动卡车发现车道障碍物之后,开始“霸凌式变道操作”。这种变道手段在国内的大型和超大型车辆上非常常见。主要原因有两点,一个是因为这种车辆往往由职业司机驾驶,职业司机虽然经验丰富但同时驾驶的激进尺度也比较大;另一个是因为这种功能性车辆因为统一运营所以有完整的保险保护,即使偶有事故,自车也不吃亏,(更恶毒地推测)与司机个体的自身安全更无威胁……大型的职工班车和土方车,以前者为最,是类似变道方式的主要发起方,相信各位多多少少在道路上都遇到过类似情况,小编几乎天天被大型班车霸凌式加塞儿,那也是真没办法。

对照上图,大型卡车在各种原因下触发变道行为时,首先动作是调整车头指向,从而拉动整车向邻道发起变道动作。可以看到V卡的指向基本是贴着邻道前车的尾部,只要邻道前车向前运动,不论快慢,都会有足够的空间让大型卡车完成这个“局部转向”动作,因为邻道后车(即Model 3)绝大多数情况下不可能紧贴着前车尾部向前行驶。

2 BYD电动卡车抢占邻道之后的态势;

上图中,大型卡车已经完成了车头头部的换道操作,在这种情况下,和步骤1中的差别在于,Model 3 的前向摄像头组件已经开始感知到了这个车辆实体的存在。如下图:

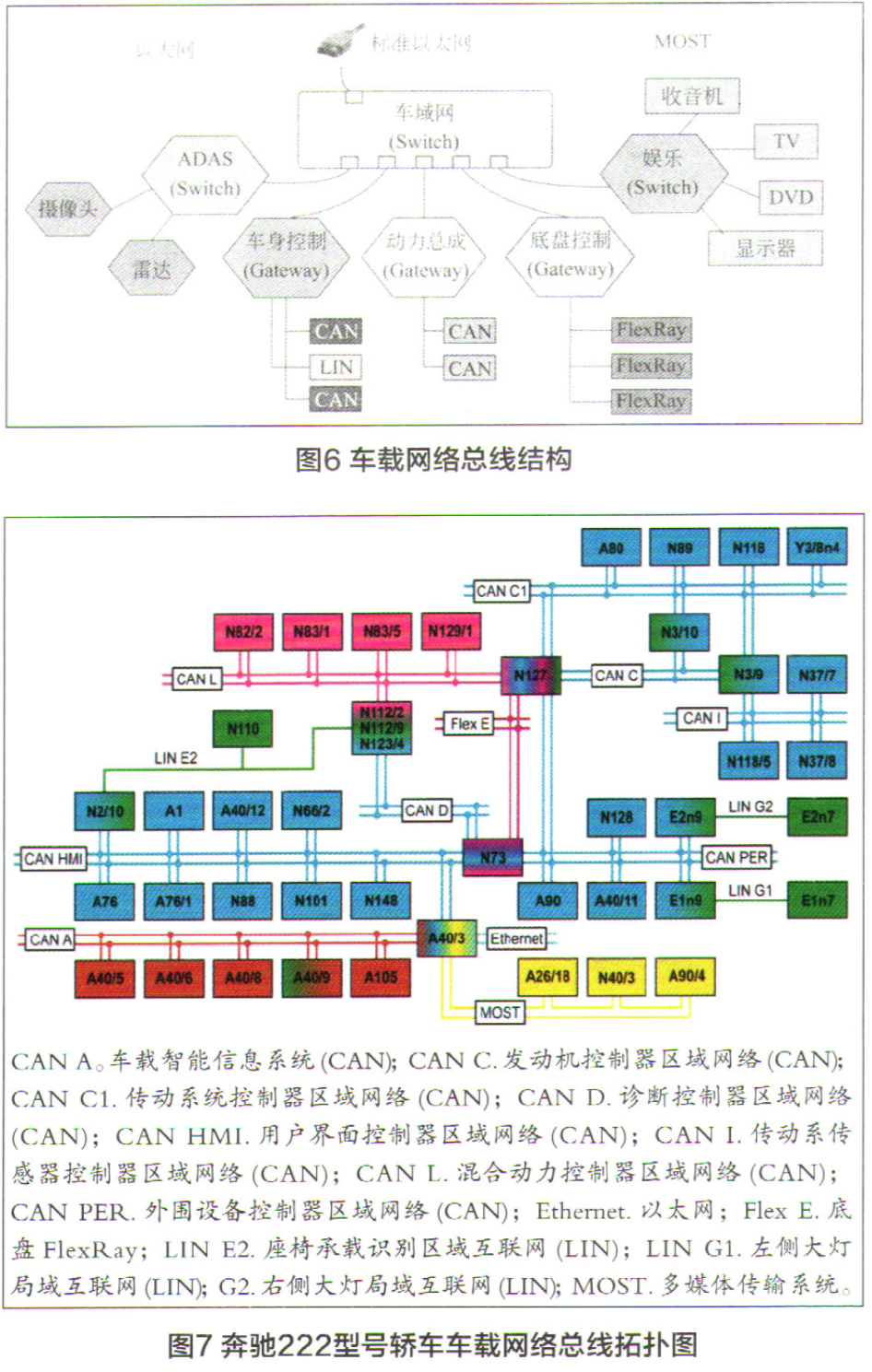

Model 3的前向摄像头模组包含一组三个Camera,上图中给出的视频信息,应该是Main Camera给出的(视角60度),除此之外还有Fisheye宽视角的Camera(视角140度)。但本质上都是一样的,不管视角宽还是窄,实际上在这个时间节点上,Model 3的前向视觉传感器,都没有办法捕捉到完整的大型卡车,只有上图这个侧脸而已。

但根据小编的经验,即便是个侧脸,前向摄像头也能据此提供目标识别和分类动作。基于视觉信息的视野内物体捕捉、定位和识别是一个相对成熟的技术范畴,下图显示为2018年中,Autopilot的技术水准。

上图六幅画面按照位置分别为Tesla车辆上的六个摄像头信息,中间的上为Fisheye,下为Main。从画面上看,对于自车两侧的两辆大车,如果不是距离足够,就一定是同时出现在多个视像头视野角度内的。比如左侧黄色大客车,在中间的Main和Fisheye,以及左侧的Pillar和Repeater之内都能看到。而右侧的对向货车,则在中间的Main和Fisheye,以及右侧的Pillar和Repeater之内也能同时观察到。

但现在的问题是,Autopilot和HW2.5之前的硬件平台,虽然能实现每个Camera范围内的目标识别和分类/测距动作,但是做不到联合识别和分类动作,这往往需要巨大的计算量,因此现有硬件无法承担这个计算量。如果读者可以看得到,可以发现,同样的一部车辆,在每个镜头内的识别ID肯定是不一样的,甚至分类也在很多情况下都不一样。

这就决定了,Autopilot的很多自动驾驶算法,只能是以前向的某部摄像头为主,其他摄像头提供的视觉信息为辅(存疑)来进行目标识别、预测和自车运动规划。举个例子,在深圳这次车祸事故中,Model 3的前向摄像头是看到了电动卡车的车头的,分类动作也不会无法执行,是有感知的。但是因为无法看到电动卡车的全貌,无法联合右侧Pillar和Repeater摄像头进行联合识别,因此前向摄像头无法精准衡量/预判这个部分车头的运动趋势……

因此虽然电动卡车车头进入前向摄像头视野,但是Autopilot的Cut-in算法网络,无法根据这有限的信息做出目标运动趋势预测,也就无法调整自己的运动规划了。

我们在很多场合下,听到过特斯拉车主抱怨说经常会遇到莫名其妙的点刹车行为,俗称“鬼刹车”。这种Autopilot的表现,实质就是对于邻道车辆(往往是能够完整落入前向摄像头视野的车辆)有可能执行换道操作的一种响应。这种对于邻道车辆的预测,必须建立在精准的识别基础之上,如果不能识别,或者识别支零破碎(每个摄像头各自为战“,那么这种识别就是效利非常低的识别,而有可能被autopilot算法所忽略。

上图即是一个精准识别的前提场景描述,在这种对于前车变道趋势的预测,是有可能导致预测的“假阳性”而催生“鬼刹车“的。但在深圳的事故中,Model 3没能拿到完整车辆的视觉信息,因此对于电动卡车的换道趋势预测发生了“假阴性”的误判,从而导致撞击发生。

3 BYD电动卡车和Model 3发生碰撞时的态势;

从上图看,即便发生了实际冲撞,前向摄像头对于电动卡车的捕捉也是很小的一部分。虽然Pillar侧向和Repeater侧后摄像头可以补全这个全车信息,但因为HW2.5不做联合处理,因此导致车辆未能减速/刹停。

但是为什么Model 3会在最后时刻向前加速呢?

上图为Model 3的Repeater摄像头信息,Pillar的内容也基本一致,角度略不一样。从这个角度看连续信息,电动卡车的尾部是以一个不小的横向速度直接靠过来的。Model 3的摄像头观察到这个横切速度之后,会独立经由autopilot的处理而做出规避响应。

问题是如何选择规避方式,A加速向前脱离侧身和尾部有可能的撞击;B左转向规避。小编的理解是,如果Autopilot可以联合识别前向和侧向所有的摄像头信息,转向是一个更好的选择(需要忽略车道线限制,并同时观察左侧车流量)。但如果是各自摄像头识别各自的视野内容,则此时Autopilot只能是根据不同输入产生不同的策略后的叠加。具体到深圳事故,就是前向摄像头虽然知道前向有障碍物(电动卡车车头),但无法预测其运动趋势;侧向摄像头却准确观察和预测到了快速的横切动作(他会认为来自于另一辆车),同时超声波也给出告警,必须规避。

因此策略叠加之后,选择了向前加速,直到撞击发生。其实从某种角度看,前侧向撞击导致可能的车辆的受损,相比侧身整体被撞击,确实会小一些。

再次总结一下:

1 尽快在大陆地区完成HW3.0硬件平台的普及;

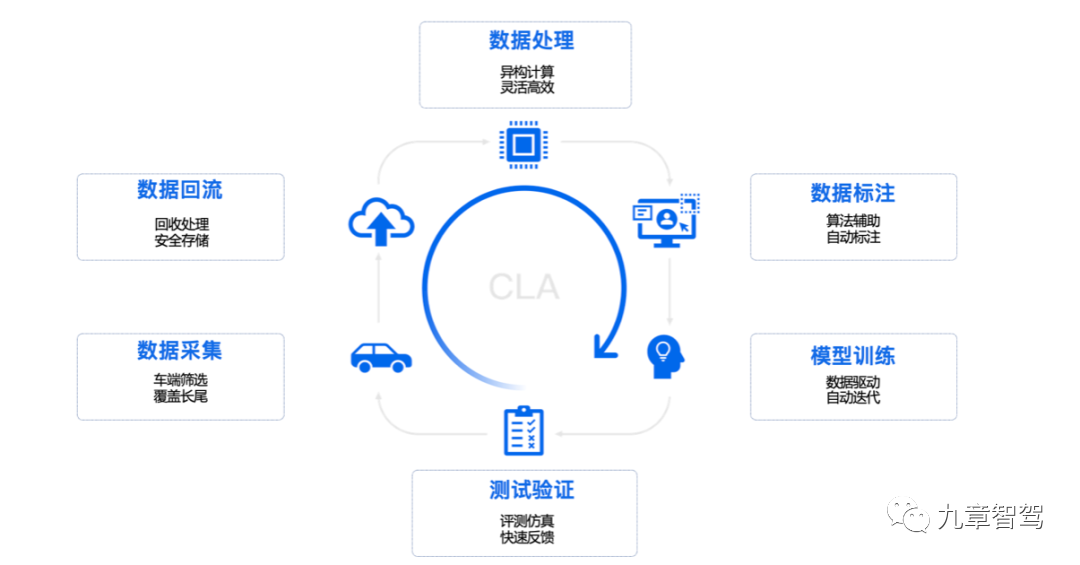

2 尽快在大陆地区部署独立的autopilot云平台,针对大陆相对特殊的路况、驾驶行为、中文标志标识,开展快速迭代和学习。

声明:本文内容及图片由BC-AUTO转载至网络,信息来源于公众号车右智能。

- 用户评论